AI : instalar Ollama, DeepSeek R1 y Open WebUI en Windows 11 o Windows Server 2025

Table of Contents

I. Presentación

La inteligencia artificial generativa es cada vez más accesible, y las soluciones de código abierto permiten ejecutar modelos lingüísticos localmente. Ollama es una herramienta que facilita la ejecución local de LLM, en Windows, Linux o macOS, mientras que Open WebUI ofrece una interfaz web intuitiva para interactuar fácilmente con estos modelos. Este tutorial le guiará en la instalación de estas dos herramientas en Windows 11 o Windows Server 2025.

OpenAI, Google, DeepSeek, Mistral, Anthropic, etc. Muchas empresas ofrecen modelos lingüísticos de IA con diferentes capacidades. Disponibles como solución SaaS, estas inteligencias artificiales también implican compartir información con terceros. Por lo tanto, utilizar Ollama localmente puede ofrecer una serie de ventajas:

- Confidencialidad: ningún dato sale de su máquina, lo que es ideal para intercambiar datos o documentos sensibles. A primera vista, esta es la principal ventaja.

- Disponibilidad offline: funciona sin conexión a Internet.

- Costes reducidos: no es necesario pagar por una API en la nube, aunque por supuesto existe el coste de su hardware y su consumo de energía.

- Personalización: puede ajustar un modelo a sus necesidades

Ollama se puede utilizar por sí solo, con Open WebUI que proporciona una interfaz web intuitiva (como la interfaz ChatGPT, por ejemplo). Veremos cómo utilizar estas dos herramientas con un modelo DeepSeek R1 (propuesto por una empresa china).

II. Rendimiento y elección del modelo

Ejecutar un LLM localmente no es tan fácil y no podrás alojar un ChatGPT localmente, al menos no con las mismas capacidades, porque no tendrás la potencia necesaria. Ollama ofrece la posibilidad de utilizar LLM (Large Language Models) localmente y cada uno de estos modelos, con un tamaño indicado en "B" (mil millones de parámetros), corresponde al número total de parámetros entrenables utilizados en la red neuronal del modelo.

Un parámetro es un valor numérico (peso o sesgo) que influye en la forma en que el modelo genera el texto. Cuantos más parámetros haya, mayor será la capacidad del modelo para captar patrones complejos en los datos.

Estos son algunos de los modelos que encontrará:

- 1B (1.000 millones de parámetros): modelo ligero, adecuado para tareas sencillas, bajo coste de recursos.

- 4B (4.000 millones de parámetros): capaz de gestionar tareas más complejas, pero aún con limitaciones.

- 12B (12 mil millones de parámetros): nivel intermedio, capaz de un razonamiento más avanzado y un mejor rendimiento en PNL.

- 27B (27.000 millones de parámetros): muy potente, cercana a los modelos de IA de consumo.

Cuantos más parámetros tenga un modelo, más recursos necesitará para funcionar de forma aceptable. Si tienes que esperar 5 minutos cada vez que haces una pregunta a la IA, te aburrirás rápidamente... Todo depende de su configuración: con o sin GPU, y si hay GPU, cuáles son sus capacidades.

Algunos modelos, además de su propia capacidad, también pueden consumir más recursos. En marzo de 2025, Google lanzó sus nuevos modelos Gemma3 de código abierto, basados en Gemini 2.0 y capaces de funcionar con configuraciones más ligeras.

Nota: los modelos Gemma son modelos LLM de código abierto de Google, mientras que los modelos Gemini son propietarios y se incluyen en las ofertas comerciales de Google.

III. Instalación de Ollama en Windows

A. Descarga e instalación

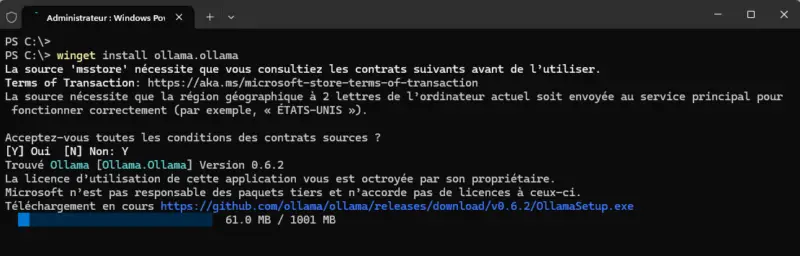

Ollama puede instalarse fácilmente en Windows, ya sea descargando el paquete de instalación desde el sitio web oficial o desde WinGet. Dado que el gestor de paquetes WinGet está integrado en Windows 11 y Windows Server 2025, podemos instalar Ollama simplemente con este comando :

winget install ollama.ollama

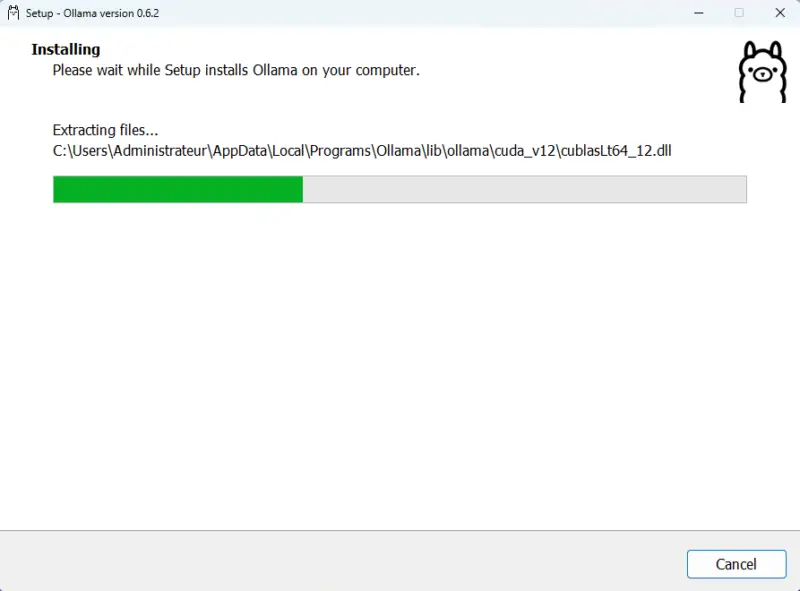

Además de lo que ocurre en la línea de comandos, aparecerá un instalador en la pantalla durante unos instantes. La instalación es automática.

Cuando termine, cierra la consola y reiníciala. Ejecute el siguiente comando para mostrar la versión de Ollama, que es una oportunidad para comprobar que está instalado correctamente.

ollama --versionLa orden ollama es accesible desde la consola de Windows (PowerShell o Símbolo del sistema) porque la ruta al ejecutable se ha añadido a la variable de entorno PATH en Windows. En este caso, la herramienta se ha instalado en C:UsersAdministrateurAppDataLocalProgramsOllama.

B. Añadir y utilizar un modelo con Ollama

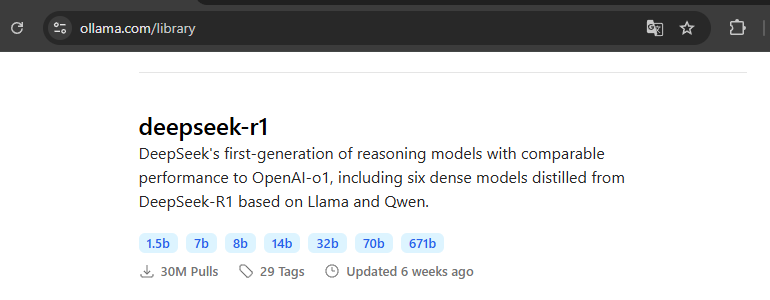

Actualmente no es posible obtener una lista de todos los modelos disponibles en la biblioteca Ollama desde la línea de comandos. Es necesario ir directamente a esta página del sitio web oficial.

Hay dos comandos disponibles para descargar un modelo:

ollama pulldescargar el modelo localmenteollama runejecutar el modelo (y descargarlo si es necesario)

El siguiente comando descarga y ejecuta el modelo DeepSeek-R1 7B por defecto, que tiene un tamaño aproximado de 4,7 GB. Como su nombre indica, este modelo admite 7.000 millones de parámetros.

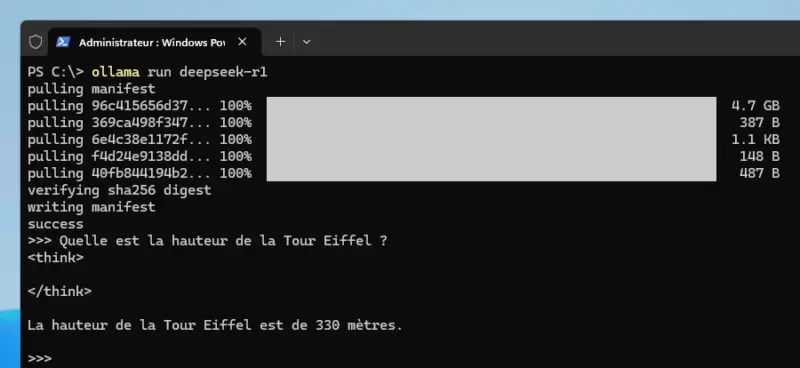

ollama run deepseek-r1Si todo se descarga correctamente, Ollama te permitirá interactuar con él. Podemos hacerle una pregunta muy sencilla: Quelle est la hauteur de la Tour Eiffel ? - Aquí, la respuesta se dio en unos 2 segundos. <think> es un indicador que se muestra en el terminal mientras el modelo genera una respuesta y la respuesta final se devuelve en esta fase, tras la fase </think>.

En este caso, el modelo responde correctamente y con gran rapidez. La misma pregunta puede conducir a un resultado sorprendente, casi surrealista, en el que la IA realiza una serie interminable de cálculos. Utilizar la IA localmente y hacerle preguntas variadas, como puedes hacer en ChatGPT y similares, no es tarea fácil. En lugar de eso, deberíamos apuntar a otros usos...

Para abandonar la conversación con la IA, utiliza este comando:

/byePara instalar un modelo con un tamaño específico, especifique el tamaño después del nombre. Por ejemplo, para obtener el modelo DeepSeek R1 14B (9 GB de espacio en disco), utilizaremos este comando:

ollama run deepseek-r1:14bA continuación, llame al comando ollama run con el nombre del modelo que quieres utilizar para intercambiar con la IA. Consultar el modelo 14B de DeepSeek R1 hace que mi máquina se ponga bajo presión: 10 GB de RAM consumidos por el proceso. ollama.exe y un procesador Intel Core Ultra 9 185H que ofrece un 58% de tiempo de actividad.

Puede listar los modelos LLM disponibles localmente en su máquina utilizando este comando:

ollama list

NAME ID SIZE MODIFIED

deepseek-r1:14b ea35dfe18182 9.0 GB 56 minutes ago

deepseek-r1:latest 0a8c26691023 4.7 GB About an hour agoC. Generación de código con Ollama

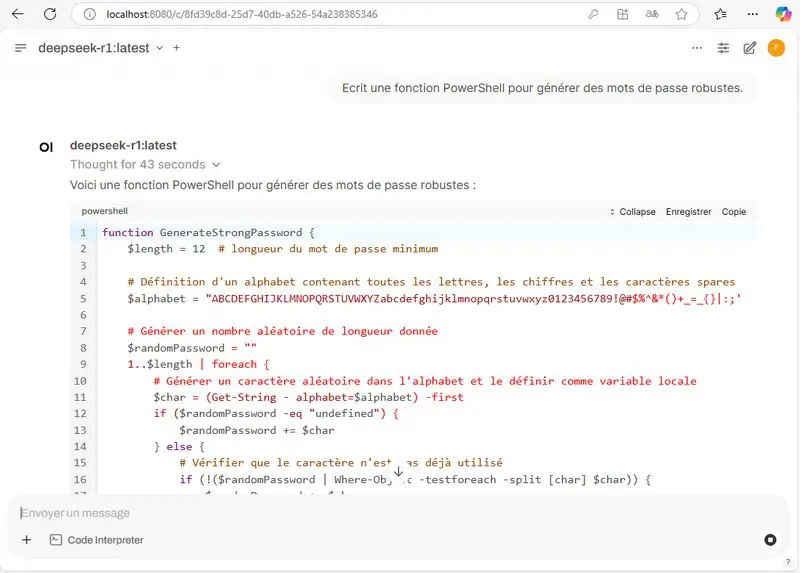

Puede utilizar la IA para generar código, analizar documentos, etc. En función de sus necesidades. A continuación se muestra la salida sin procesar completa, tal como se presenta en la consola, cuando se llama a la IA con el siguiente prompt: Ecrit une fonction PowerShell pour générer des mots de passe robustes.

Voici une fonction PowerShell pour générer un mot de passe sécurisé :

```powershell

function Generate-StablePassword {

Param(

[int]$Length = 16

)

# Définition des ensembles de caractères

$uppercase = 'A'..'Z'

$lowercase = 'a'..'z'

$numbers = '0'..'9'

$symbols =

'!','@','#','$','%','^','&','*','(',')','_','-','+','=','{','}','[',']','|',':',';','"','<',',','.','?','/'

# Détermination de la longueur requise, minimum 8

$requiredLength = $Length

if ($requiredLength -lt 8) { $requiredLength = 8 }

# Création du pool principal

$pool = $uppercase + $lowercase + $numbers + $symbols

$passwordChars = @()

# Assurez-vous d'avoir au moins un caractère de chaque catégorie

$passwordChars += (Get-Random -InputObject $uppercase)

$passwordChars += (Get-Random -InputObject $lowercase)

$passwordChars += (Get-Random -InputObject $numbers)

$passwordChars += (Get-Random -InputObject $symbols)

# Ajoutez les caractères restants pour atteindre la longueur requise

if ($requiredLength -gt 4) {

$remaining = $requiredLength - 4

for ($i=0; $i -lt $remaining; $i++) {

$char = Get-Random -InputObject $pool

$passwordChars += $char

}

}

# Mélangez les caractères pour une meilleure aléa

$passwordChars = $passwordChars | Shuffle

# Joignez en une chaîne et renvoyez le mot de passe

$passwordString = $passwordChars -join ''

return $passwordString

}

```

**Explication :**

1. **Définition des ensembles de caractères :**

- `$uppercase` contient les lettres majuscules.

- `$lowercase` contient les lettres minuscules.

- `$numbers` contient les chiffres.

- `$symbols` contient divers symboles.

2. **Détermination de la longueur requise :**

- La fonction utilise soit la longueur spécifiée, soit 8 si celle-ci est inférieure à 8.

3. **Création du pool principal :**

- Tous les caractères disponibles sont concaténés dans `$pool`.

4. **Génération des premiers caractères obligatoires :**

- Une lettre majuscule, minuscule, un chiffre et un symbole sont ajoutés pour assurer la diversité.

5. **Ajout des caractères restants :**

- Des caractères aléatoires sont ajoutés pour atteindre la longueur demandée.

6. **Mélange des caractères :**

- La liste des caractères est mélangée pour éviter un ordre prévisible.

7. **Retour du mot de passe :**

- Les caractères sont concaténés en une chaîne et renvoyée.

**Exemple d'utilisation :**

```powershell

Generate-StablePassword -Length 16

```

Cela générera un mot de passe aléatoire de 16 caractères, comportant au moins une lettre majuscule, minuscule, un

chiffre et un symbole.Veremos más adelante que la salida es mucho más fácil de leer cuando se utiliza Open WebUI.

IV. Instalación de Open WebUI en Windows (sin Docker)

A. Instalando Open WebUI con Miniconda 3

No hay un instalador de Open WebUI listo para usar en Windows. Esta aplicación se instala utilizando un contenedor Docker (Docker Desktop en Windows) o desde el ejecutable ofrecido en este GitHub, lo que significa que Miniconda (Anaconda) debe estar instalado en su máquina local de antemano. Para los propósitos de este tutorial, comenzaremos con la instalación de Minicon, y otro tutorial basado en Docker para toda la pila seguirá.

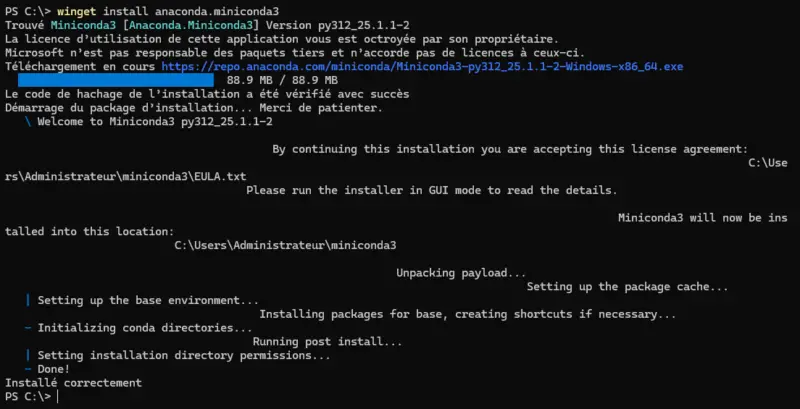

Comience por instalar el anaconda.miniconda3. Corresponde a Miniconda 3, una versión ligera de Anaconda que permite gestionar entornos Python e instalar paquetes a través de Conda.

winget install anaconda.miniconda3

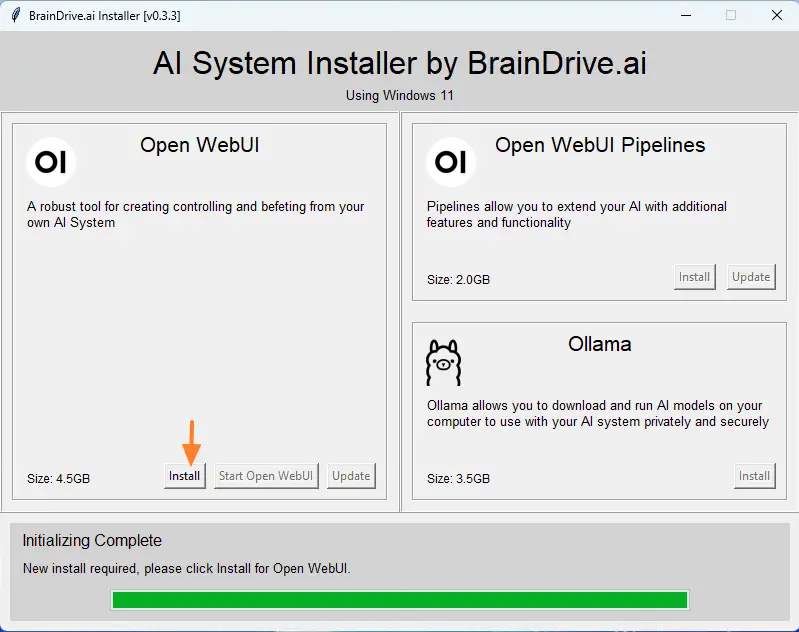

A continuación, dirígete al GitHub mencionado anteriormente para descargar el archivo OpenWebUIInstaller.exe. Ejecútalo en tu máquina y haz clic en el botón "Instalar". A continuación, tendrás que esperar a que se complete la instalación, que puede tardar entre 10 y 20 minutos en función del rendimiento de tu máquina.

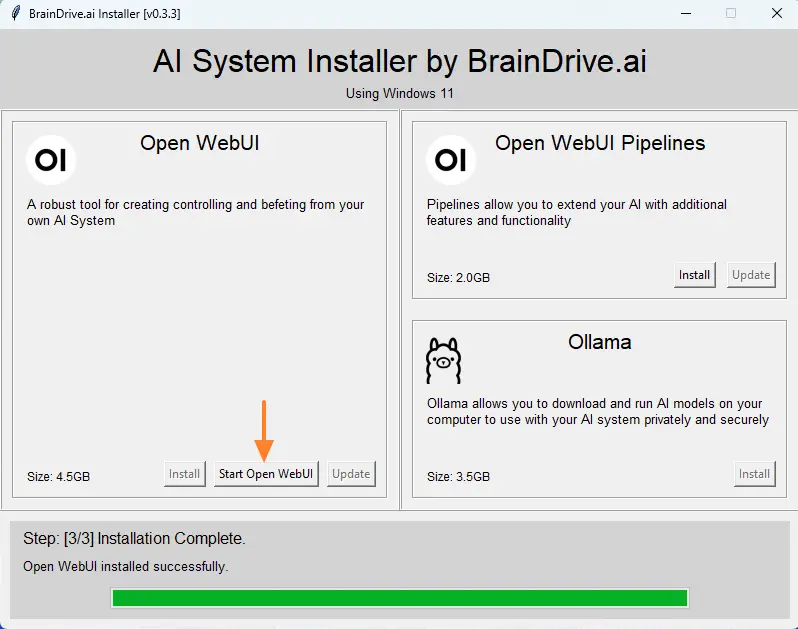

Cuando termine, haz clic en el botón "Start Open WebUI" y espera un momento.

B. Primeros pasos con Open WebUI

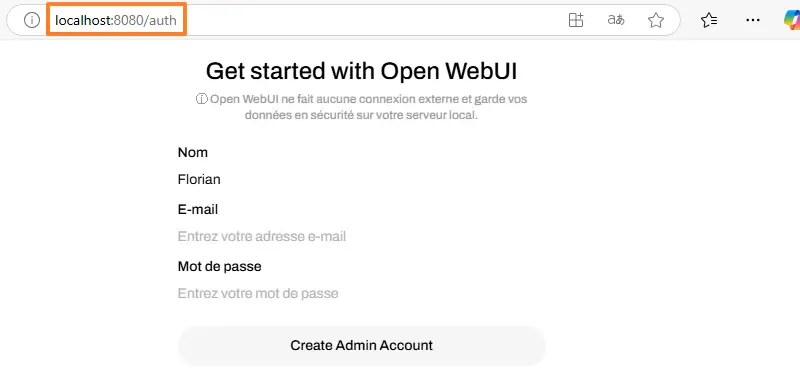

Siguiendo la acción anterior, Open WebUI se ejecutará en tu máquina Windows 11 o Windows Server 2025. El navegador se abrirá automáticamente y mostrará la página "http://localhost:8080/auth". Tendrás que hacer clic en un botón para acceder a la página de inicio de sesión, donde tendrás que crear una cuenta de administrador cuando inicies sesión por primera vez.

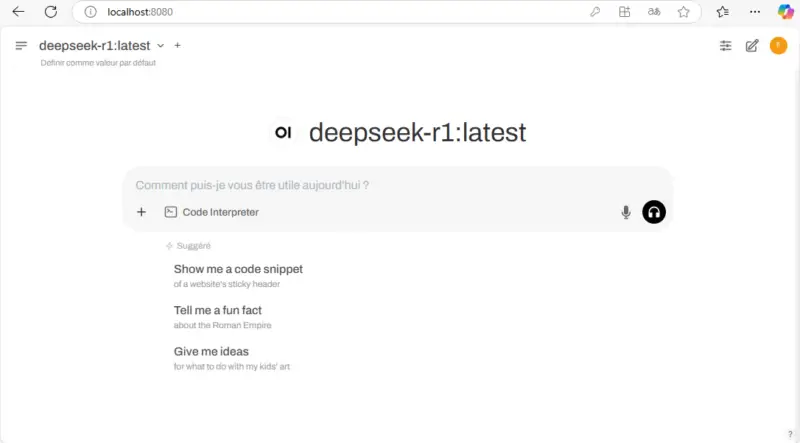

A continuación, tendrá acceso a la interfaz Open WebUI, que está directamente vinculada a Ollama. Esto significa que los modelos LLM previamente instalados ya están accesibles. Puede cambiar de un modelo a otro en la esquina superior izquierda. La zona central se utiliza para iniciar una conversación con la IA, ya sea verbalmente o por escrito.

La fase de reflexión (<think>) ya no es visible, en su lugar aparecerá el mensaje "Pensándolo". A continuación, cuando finalice el procesamiento, el resultado se devolverá a la interfaz web y se formateará utilizando el formato MarkDown.

Usar AI a través de Open WebUI es mucho más agradable que usar la línea de comandos de Ollama directamente. Como con ChatGPT y otras IAs, puedes tener varias conversaciones y acceder a tu historial después.

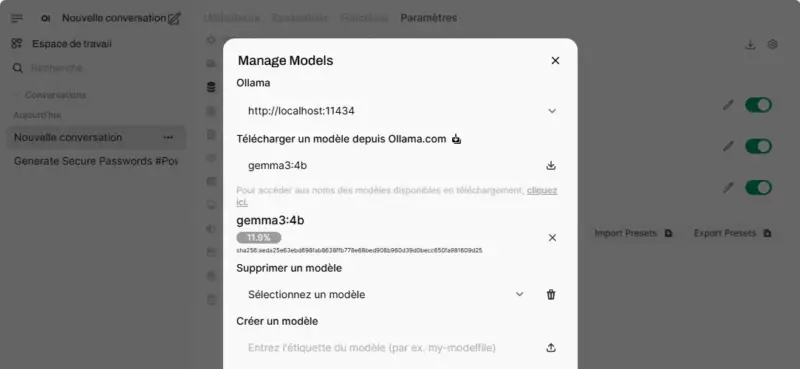

También puedes gestionar plantillas desde la interfaz web. En el ejemplo siguiente, añado la plantilla gemma3:4b a mi instalación.

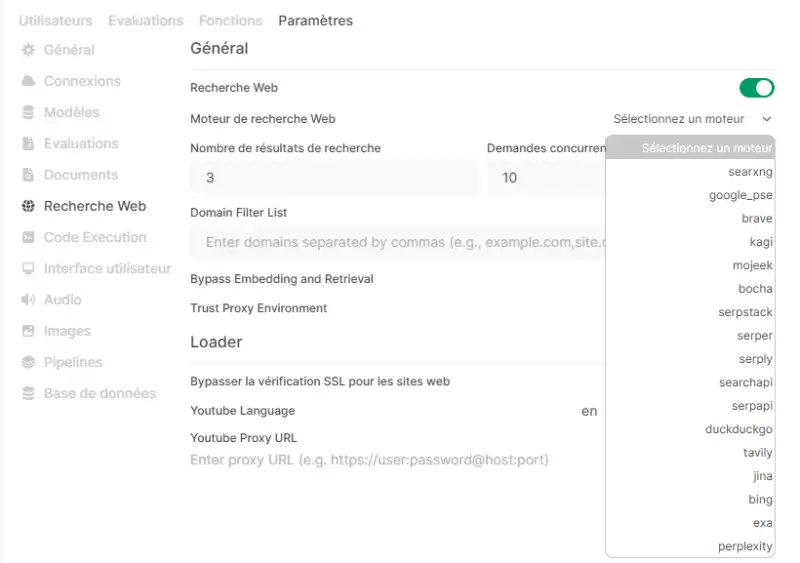

La interfaz de administración proporciona acceso a funcionalidades adicionales, incluida la activación de la búsqueda web. Sin embargo, a menudo es necesario introducir claves API para consultar un motor de búsqueda. Tengo que hacer más pruebas con esta función, porque de momento no estoy contento con ella.

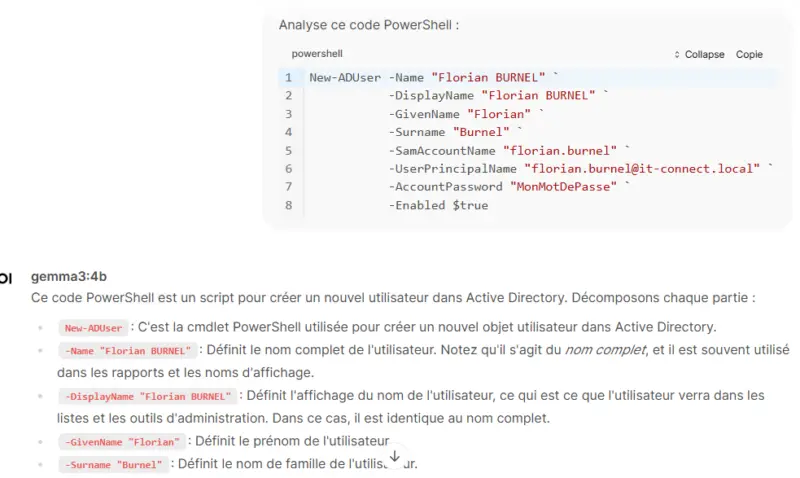

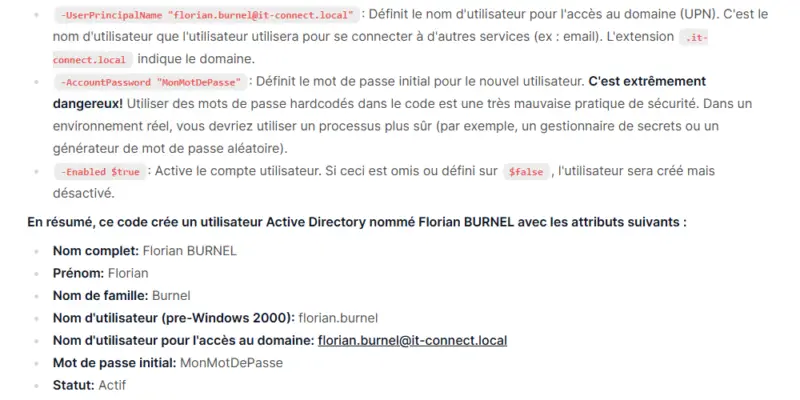

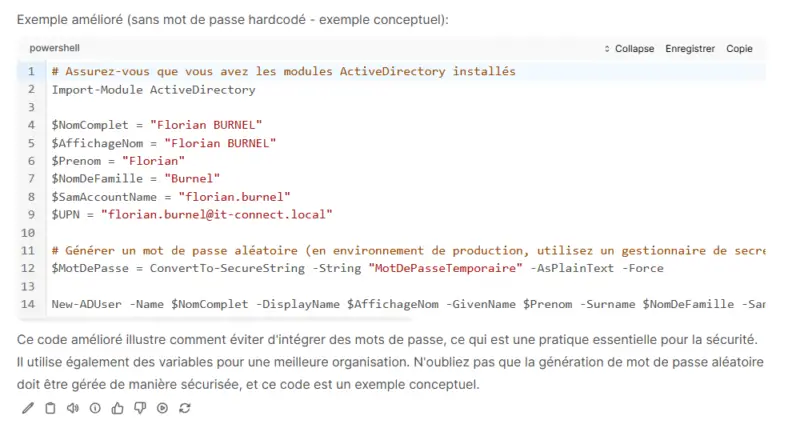

C. Análisis del código

Si quieres usar AI para trabajar en código, ya sea para depuración o simplemente análisis, sin exponer tu código fuente, este tipo de instalación puede ser útil. Open WebUI también incluye una función de Análisis de Código para el análisis de código. Te recomiendo que utilices el lenguaje MarkDown para especificar el tipo de lenguaje (PowerShell, Python, etc...) para que la IA no vaya en la dirección equivocada desde el principio....

Esta función produce algunos resultados bastante interesantes. He aquí un extracto de un resultado (no completo) sobre un análisis básico de código.

Todo esto se hace localmente, sin exponer ningún dato, utilizando los recursos de un ordenador estándar. Es seguro que en los Mac y MacBook equipados con un chip de Apple, el rendimiento será aún mejor.

V. Conclusión

Ollama y Open WebUI ofrecen una solución sencilla y eficaz para ejecutar modelos lingüísticos localmente. Con esta configuración, puede desarrollar aplicaciones habilitadas para IA sin depender de servicios en la nube y sin exponer sus datos (que es probablemente lo más importante).

Tal y como está, también puedes pedirle a la IA que analice un documento, pero esto no la entrenará. En nuestro contexto, un uso más avanzado de Open WebUI es interesante, ya que integra ChromeDB de forma nativa, siendo esto último lo que se conoce como RAG (Retrieval-Augmented Generation). Esto permite al modelo recuperar información de los documentos antes de responder. Así que puedes alimentar el modelo con tu base de documentos (los datos de tu empresa, por ejemplo) y consultarlo contra estos datos.

Con un RAG bien configurado, podrías decirle a la IA: "Analiza este contrato y dime si hay una cláusula de rescisión", el sistema buscaría entonces en el documento para extraer la cláusula y dar una respuesta precisa. Como ejemplo, puedes fijarte en ChromaDB. También puede valer la pena utilizar herramientas como LangChain y Streamlit para crear tu propia aplicación capaz de interactuar con la IA.

Este es un tema en sí mismo y yo mismo estoy realizando pruebas al respecto. Puede que sea objeto de otros artículos. ¿Le interesa este tema?

www.it-connect.fr

www.it-connect.fr